先說結論,BERT Checkpoint 到底是什麼?

好,今天來聊聊 Google BERT Checkpoint。很多人,特別是剛接觸 NLP (自然語言處理) 的朋友,一聽到「Checkpoint」這個詞,可能馬上聯想到打電動的「存檔點」。欸,你別說,這個比喻還真的挺傳神的。它就是模型在訓練到某個階段時,把所有學到的東西打包存起來的一個「快照」。

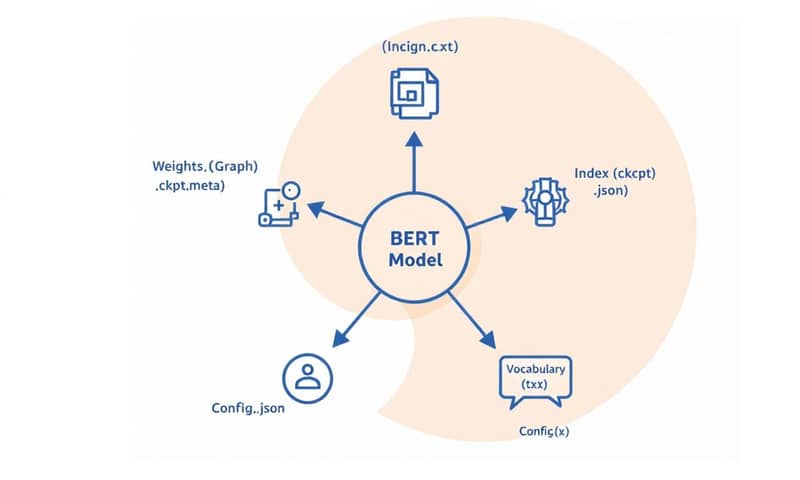

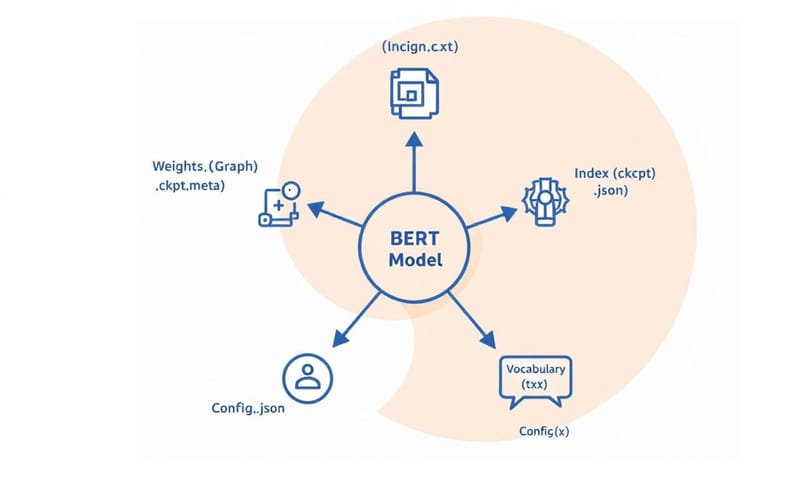

但重點來了,它不是一個單獨的檔案。這點真的要畫螢光筆。當你從 Google 下載一個預訓練好的 BERT 模型時,你會得到一包東西。 這個「快照」其實是一組檔案的集合,裡面記錄了模型當時的所有狀態,包括但不限於它學到的所有參數(也就是權重)。 你可以把它想像成一個人的大腦在某個時刻的完整拷貝,不只記得學過的知識,還包括思考的方式。有了這個快照,你就可以隨時讓模型「讀檔」,回到那個狀態,繼續訓練,或者直接拿來做預測。 這超級省時省力,不然每次都要從零開始訓練,那個計算成本會高到嚇死人。

所以,Checkpoint 到底長怎樣?

說了半天,這包「快照」裡面到底裝了什麼?如果你解壓縮從 Google 官方下載的 BERT-Base 模型,你會看到至少三個核心檔案。 沒錯,就是這三兄弟,它們缺一不可:

- bert_model.ckpt.meta:這個檔案你可以把它看成是模型的「建築藍圖」。它描述了整個計算圖的結構——有哪些層、每層長什麼樣子、變數是什麼等等。它定義了模型的骨架,但裡面沒有填上血肉(也就是權重)。

- bert_model.ckpt.index:這個檔案像是個「索引目錄」。它告訴 TensorFlow 哪個變數(權重)存在哪裡。因為模型可能很大,權重會被切分成好幾個部分儲存,這個索引檔就是用來快速查找的。

- bert_model.ckpt.data-00000-of-00001:這才是真正儲存模型「血肉」的地方,也就是所有訓練好的權重數值。檔名後面的數字表示這是第 1 個分片檔,總共有 1 個分片。如果模型更大,可能會有多個 data 檔案。

除了這三個跟模型權重直接相關的檔案,通常還會跟著另外兩個很重要的夥伴:

- bert_config.json:這個 JSON 檔案儲存了 BERT 模型的超參數設定。 像是它有幾層 Transformer Encoder (BERT-Base 是 12 層)、隱藏層維度多大 (768)、有幾個注意力頭 (12) 等等。 要載入模型,光有權重還不夠,還必須知道當初是用什麼樣的架構訓練的,這個設定檔就是做這件事。

- vocab.txt:這是一個純文字檔,裡面是詞彙表。 每一行就是一個字或是一個 token (像是 `[CLS]`, `[SEP]`)。模型在處理文字時,需要把文字轉換成數字 ID,這個檔案就是它們的對照表。如果載入模型時用了錯誤的詞彙表,那結果就全亂了。

怎麼把它們叫起來用?從 TensorFlow 到 Hugging Face

好,現在我們有這包檔案了,該怎麼用?這就要看你用什麼工具了。方法主要分成「古典派」和「現代派」。

古典派:原生 TensorFlow 的方式

最早 BERT 是用 TensorFlow 寫的,所以最原始的方式就是用 TensorFlow 的 `tf.train.Saver` 來讀取。 不過老實說,現在除非有特殊理由,不然很少人會這樣做了。程式碼會比較繁瑣,要自己定義好跟 `bert_config.json` 一模一樣的模型結構,然後再手動把 checkpoint 裡的權重填進去。 過程有點像在組裝電腦,每個零件都要自己對好。這個方式彈性最大,但也很容易出錯。

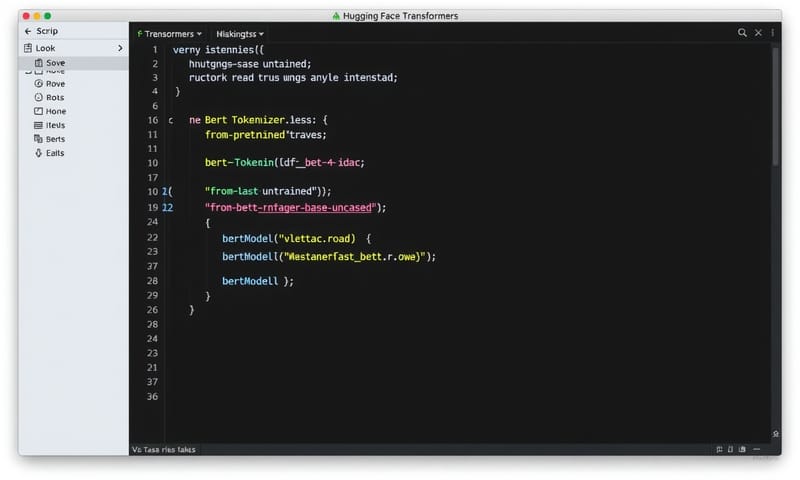

現代派:Hugging Face Transformers 函式庫

現在幾乎所有人都用 Hugging Face 的 `transformers` 函式庫了。它把所有繁瑣的步驟都包裝好了,你只要一行程式碼就能搞定。 Hugging Face 很聰明,它提供了一個轉換腳本 `convert_tf_checkpoint_to_pytorch.py`,可以把 Google 原生的 TensorFlow checkpoint 轉成 PyTorch 格式(通常是 `pytorch_model.bin`)。 轉好之後,配合 `bert_config.json` 和 `vocab.txt`,就可以用 `from_pretrained()` 這個萬用方法直接載入。

from transformers import BertModel, BertTokenizer

# 假設你的 checkpoint 檔案、config 和 vocab 都在 'path/to/your/bert_model' 資料夾下

model_path = 'path/to/your/bert_model'

# 載入 tokenizer 和 model

tokenizer = BertTokenizer.from_pretrained(model_path)

model = BertModel.from_pretrained(model_path)

# 之後就可以直接用了

inputs = tokenizer("你好,世界", return_tensors="pt")

outputs = model(**inputs)

last_hidden_states = outputs.last_hidden_state

你看,是不是超級簡單?Hugging Face 會自動判斷你要載入的是 TensorFlow checkpoint 還是 PyTorch 模型,然後在背後默默幫你處理好一切。 這也是為什麼它會成為現在 NLP 領域的主流工具。

Checkpoint 的演進:從 .ckpt 到 .safetensors

聊到模型儲存,就不能不提一個重要的趨勢:檔案格式的演進。最早的 `.ckpt` 格式雖然是 TensorFlow 的標準,但它有一些天生的問題。這幾年,特別是在 Hugging Face 和 Stable Diffusion 社群的推動下,一個新的、更安全的格式 `.safetensors` 崛起了。

我自己是覺得,這個演變背後反映了整個 AI 社群對安全性跟效率的重視。`.ckpt` 檔案是使用 Python 的 `pickle` 模組來序列化的。 `pickle` 的問題在於它很不安全,一個惡意的 `.ckpt` 檔案理論上可以在你的電腦上執行任意程式碼。 這對於一個大家習慣在網路上分享模型的生態系來說,是個超大的安全隱憂。

於是,Hugging Face 開發了 `safetensors`。 它有幾個關鍵優點:

- 安全性:它不依賴 `pickle`,所以沒有執行任意程式碼的風險。你下載模型的時候會安心很多。

- 速度快:`safetensors` 在載入模型時非常快,因為它採用了「零複製 (zero-copy)」的技術,可以直接把檔案內容映射到記憶體,不用多一道複製手續。 對於動輒幾 GB、幾十 GB 的大模型來說,這載入時間差很多。

- 跨平台:它是一個獨立的格式,不跟特定框架(像 TensorFlow 或 PyTorch)綁死,這讓模型在不同框架間的轉換更容易。

底下我整理了一個簡單的比較表,讓你感受一下它們的差別。

| 格式 | 優點 | 缺點 | 我自己的碎碎念 |

|---|---|---|---|

| TensorFlow `.ckpt` | - TensorFlow 原生支援 - 儲存訓練狀態很完整 |

- 有 `pickle` 安全風險 - 檔案可能很大 - 跟框架綁定較深 |

真的是時代的眼淚了。現在除非維護舊專案,不然我幾乎不會主動存成這個格式了。 |

| PyTorch `.bin` / `.pth` | - PyTorch 生態系主流 - 相對 `.ckpt` 靈活 |

- 預設還是用 `pickle` - 檔案載入速度普通 |

比 `.ckpt` 好一些,但還是有安全問題。Hugging Face 現在預設都推 `safetensors` 了。 |

| `safetensors` | - 安全,沒有 `pickle` 漏洞 - 載入速度飛快 - 跨平台、框架獨立 |

- 比較新,有些舊工具可能不支援 | 這絕對是未來趨勢,沒理由不用!現在下載模型,我一定優先選 `.safetensors` 版本,安心又快速。 |

在地觀點:台灣社群怎麼看 BERT?

講到 BERT 的應用,國外的教學當然很多,但看看台灣本地的討論也很有趣。我發現台灣的開發者社群,像是 iT 邦幫忙或是 PTT,大家更關注「如何把 BERT 用在解決中文世界的 spezifische 問題」。例如,台大李宏毅教授的教學影片就在社群中影響深遠,很多人都是看著他的影片入門的。 他的講解方式讓 BERT 這種複雜的模型變得親民很多。

更有趣的是,HTC 旗下的 DeepQ 團隊還針對台灣的語言環境,開發了一個叫做 T-BERT 的模型。 這個模型不只懂國語,還能處理台語跟客語,這就是非常在地的應用了。 這也凸顯了一個重點:Google 官方釋出的 `bert-base-chinese` 模型雖然強大,但它的訓練語料是簡體中文為主,用在繁體中文、甚至台灣特有的語言情境時,有時候還是會水土不服。因此,許多台灣的團隊和研究者會拿官方模型當基礎,再用本地的資料集(例如新聞、論壇文章)去做 further pre-training 或 fine-tuning,來讓模型更「接地氣」。 這種結合全球先進模型與在地化需求的作法,我自己覺得是台灣 NLP 發展一個很重要的特色。

常見錯誤與修正

在載入 BERT Checkpoint 的時候,新手常會踩到一些坑。這裡列舉幾個我以前也卡關過的地方,希望能幫你少走點冤枉路。

- 路徑指定錯誤:`from_pretrained()` 這個函式非常方便,但它要的是一個包含 `config.json`、`vocab.txt` 和模型權重檔的「資料夾路徑」,而不是直接指向 `.ckpt` 檔案本身。很多人會搞錯,然後就出現找不到檔案的錯誤。

- 模型與 Tokenizer 不匹配:你用的 Tokenizer 跟你的 Model 一定要是一對的。例如你用了 `BERT-Base, Uncased` 的模型,就要用 `BERT-Base, Uncased` 的 Tokenizer。如果混用,例如用 Cased 模型的權重去配 Uncased 的詞彙表,那模型看到的 ID 跟它當初訓練時的认知就完全對不上了,結果當然是災難。

- TensorFlow/PyTorch 版本衝突:虽然 Hugging Face 尽力兼容,但有时候还是会因为你的本地环境 TF 或 PyTorch 版本太旧或太新,导致一些底层的 API 不兼容而出错。所以,保持函式庫版本在一個穩定且被廣泛支援的範圍內很重要。

- Checkpoint 格式不完整:就像前面說的,一個完整的 checkpoint 是一整包檔案。有時候下載不完全,少了 `config.json` 或 `vocab.txt`,程式就會直接報錯說找不到設定或詞彙表。載入前,最好先進資料夾檢查一下檔案是否齊全。

總之,處理 Checkpoint 的核心原則就是:確保「權重」、「設定」和「詞彙」三位一體。只要這三樣東西是正確配對且齊全的,基本上就不會出太大的問題。

換你分享了!

你在處理模型 checkpoint 時,遇過最頭痛的問題是什麼?是檔案太大、格式不相容、版本管理混亂,還是有其他更奇怪的坑?在下面留言分享一下你的經驗吧!